人工智能。 第二部分:灭绝还是不朽?

以下是系列文章的第二部分“等等,这怎么可能成为现实,为什么在每个角落都没有谈到它。” 在前一个系列中,人们知道智力的爆发正逐渐蔓延到地球上的人们,它正试图从狭隘的聚焦到普遍的人类智能,最后是人工超级智能。

“或许,我们面临着一个极其复杂的问题,目前尚不清楚它的解决方案需要多少时间,但人类的未来可能取决于其解决方案。” - 尼克博斯特罗姆

文章的第一部分开始无辜。 我们讨论了狭隘的人工智能(AII,它专门解决一个特定的任务,比如确定路线或下棋),在我们的世界中它是很多。 然后,他们分析了为什么从UII(AOI或AI,根据智力能力,可以将其与一个人在解决任何任务中进行比较)来推广广义人工智能是如此困难。 我们得出结论,技术进步的指数率暗示OII可能很快出现。 最后,我们决定一旦机器达到人类智能水平,就会立即发生以下情况:

像往常一样,我们看屏幕,不相信人工超级智能(ICI,比任何人都聪明得多)已经出现在我们的生活中,并选择最能反映我们对这个问题的看法的情绪。

在我们深入研究特定的ICI之前,让我们自己提醒一下机器是否超级智能化。

主要区别在于快速超级智能和高质量的超级智能。 通常,想到超级智能计算机时首先要想到的是,他能够比一个人更快地思考 - 速度快了数百万倍,并且在五分钟内就能理解一个人十年后所需要的东西。 (“我知道功夫!”)

这听起来令人印象深刻,ISI真的应该比任何人都更快地思考 - 但主要的分离特征将是他的智力的质量,这是另一个。 人们比猴子聪明得多,不是因为他们思考得更快,而是因为人们的大脑包含许多巧妙的认知模块,这些模块可以进行复杂的语言表征,长期规划,抽象思维,猴子无法做到这一点。 如果你将猴子的大脑驱散了一千次,它就不会变得比我们聪明 - 即使十年之后它也无法按照说明组装设计师,一个人最多需要几个小时。 猴子从未学过的东西,无论花费多少小时或大脑的工作速度有多快。

此外,猴子不知道人性如何,因为它的大脑根本无法实现其他世界的存在 - 猴子可能知道一个人是什么,摩天大楼是什么,但他永远不会明白摩天大楼是由人建造的。 在她的世界里,一切都属于大自然,猕猴不仅无法建造摩天大楼,而且还了解任何人都可以建造摩天大楼。 这是智力质量差异很小的结果。

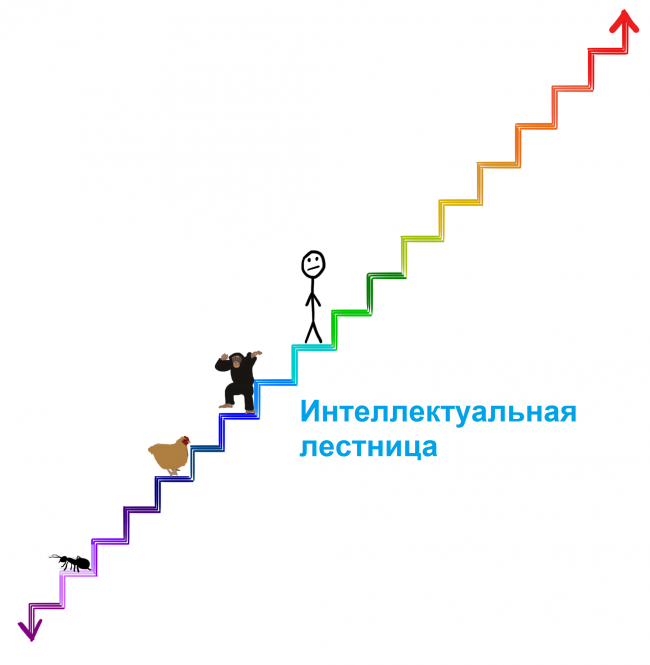

在我们所谈论的智力的一般方案中,或者仅仅通过生物生物的标准,人和猴子的智力质量的差异是微小的。 在上一篇文章中,我们将生物认知能力放在了阶梯上:

要了解超级智能机器的严重程度,请将其放在比此梯子上的人高两级的位置。 这台机器可能相当多,但它优于我们的认知能力将与我们的相同 - 超过猴子。 而且由于黑猩猩永远不会理解可以建造摩天大楼,我们可能永远无法理解机器会在更高的几个步骤上理解什么,即使机器试图向我们解释它。 但这只是几个步骤。 这辆车会让我们看到更聪明的蚂蚁 - 它会告诉我们多年来最简单的东西,这些尝试将完全没有希望。

我们今天要讨论的超级智能类型远远超出了这个阶梯。 这是一种智能爆炸 - 当机器越聪明时,它就越快地增加自己的智能,逐渐增加动力。 这样的机器可能需要数年时间才能超越智能黑猩猩,但也许需要几个小时才能超过我们几步。 从现在开始,机器每秒可以跳过四步。 这就是为什么我们应该在第一次之后很快就明白这一点 新闻 机器已达到人类智能水平,我们可以面对地球上共存的现实,在这个梯子上会比我们高得多(可能高出数百万倍):

而且由于我们已经确定,试图理解仅比我们高两级的机器的功能是绝对无用的,让我们一劳永逸地定义无法理解ICI将做什么以及对我们的后果。 任何声称相反的人都不明白超级智能意味着什么。

进化已经慢慢地逐渐发展了数亿年的生物大脑,如果人类创造出具有超级智能的机器,从某种意义上说,我们将超越进化。 或者它将成为进化的一部分 - 也许进化是这样的,智力逐渐发展,直到它达到一个转折点,预示着所有生物的新未来:

由于我们稍后将讨论的原因,科学界的很大一部分人认为问题不在于我们是否达到了这个转折点,而是在何时。

我们在这之后在哪里?

我想在这个世界上没有人,我和你都不能说出当我们到达转折点时会发生什么。 牛津哲学家和领导理论家AI Nick Bostrom认为,我们可以将所有可能的结果减少到两大类。

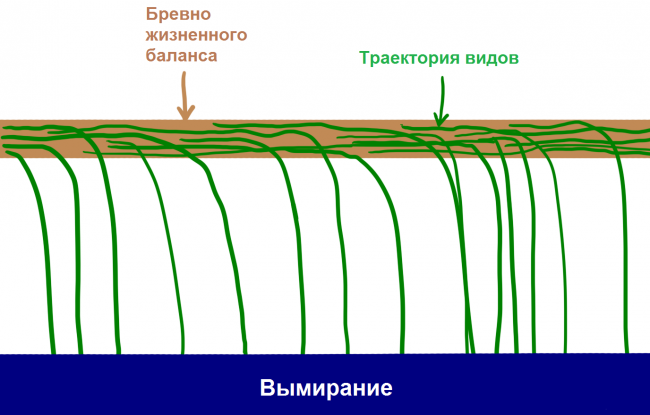

首先,看看 历史我们知道关于生命的以下内容:物种出现,存在一段时间,然后不可避免地从生命平衡的平衡中消失并消亡。

“所有物种都在消亡”,这在历史上是可靠的,因为“所有人终有一天会死”。 99,9%的物种已经从生命日志中掉落,很明显,如果某个物种在这个日志上停留太久,一阵自然风或突然的小行星会使这个日志倒置。 博斯特罗姆称灭绝是一种吸引子的状态 - 一个所有物种均衡的地方,以免在没有物种从那里返回的地方掉落。

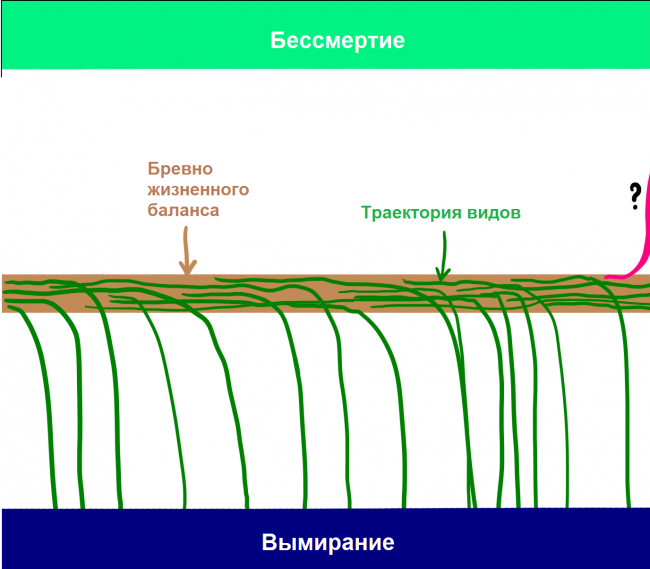

虽然大多数科学家认识到ISI将有能力使人灭绝,但许多科学家还认为,利用ISI的能力将使个体(以及整个物种)能够实现吸引子的第二种状态 - 物种不朽。 博斯特罗姆认为,物种的不朽与物种灭绝的吸引力是相同的,也就是说,如果我们达到这个目的,我们将注定永恒的存在。 因此,即使所有物种在当天之前从这根竿子掉入灭绝的池中,博斯特罗姆认为原木有两面,地球上根本没有这样的情报能够理解如何落到另一边。

如果博斯特罗姆和其他人是正确的,并且从我们可获得的所有信息来看,他们很可能是,我们需要采取两个非常令人震惊的事实:

ISI在历史上首次出现将为该物种带来永生,并使其脱离致命的灭绝循环。

ICI的出现将产生如此难以想象的巨大影响,它可能会将人类从这个日志中推向一个方向或另一个方向。

当进化到达这样一个转折点时,它总有可能结束人与生命之流的关系,并创造一个与人有关的新世界。

这导致了一个有趣的问题,即只有懒惰的人才会问:我们什么时候才能到达这个转折点,他将在何处决定我们? 世界上没有人知道这个双重问题的答案,但是许多聪明的人几十年来一直试图理解这一点。 本文的其余部分我们将了解它们的用途。

* * *

我们从这个问题的第一部分开始:什么时候应该到达转折点? 换句话说:在第一台机器达到超级智能之前剩下多少时间?

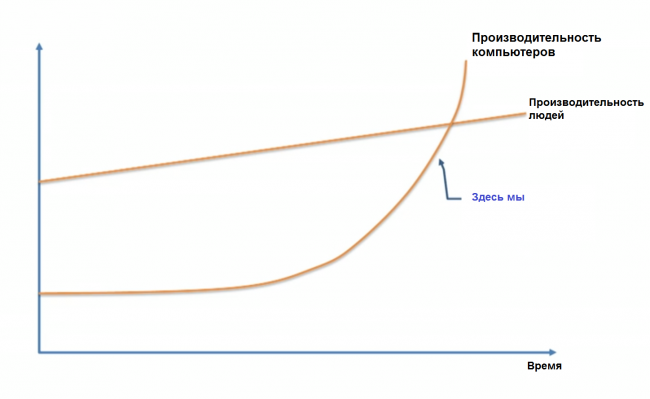

意见因案例而异。 许多人,包括Vernor Vinge教授,科学家Ben Herzl,Sun Microsystems的共同创始人Bill Joy,未来学家Ray Kurzweil,同意机器学习专家Jeremy Howard在TED演讲中提出以下图表:

这些人认为ISI很快就会出现 - 这种指数增长对我们今天来说似乎很慢,在未来几十年内会逐渐爆发。

微软联合创始人保罗·艾伦,研究心理学家加里·马库斯,计算机专家欧内斯特·戴维斯和技术专家米奇·卡普尔等人认为像Kurzweil这样的思想家严重低估了问题的严重程度,并认为我们并没有如此接近转折点。

Kurzweil Camp反对唯一低估的是忽视指数增长,你可以将怀疑者与那些在1985中看到慢慢增长的互联网并且声称它不会在不久的将来影响世界的人进行比较。

“怀疑者”可以抵挡,并表示当涉及到智力的指数发展时,每一个后续步骤都难以取得进展,而智力是技术进步的典型指数性质。 等等。

尼克博斯特罗姆所在的第三个阵营既不同意第一阵营,也不同意第二阵营,认为a)所有这一切都可以在不久的将来完全发生; b)不保证会发生这种情况或需要更长时间。

其他人,比如哲学家休伯特·德雷福斯,相信所有这三个群体天真地认为一般会有一个转折点,而且很可能,我们永远不会得到ISI。

当我们把所有这些意见放在一起会发生什么?

在2013,博斯特罗姆进行了一项调查,在一系列关于以下主题的会议上,他采访了数百名人工智能领域的专家:“你对实现人类OIH的预测是什么?”并要求说出一个乐观的一年(我们将在其中设置OII与10) - 概率百分比),一个现实的假设(我们拥有OII的50百分比概率的年份)和一个有信心的假设(OII以90百分比概率出现的最早年份)。 结果如下:

* 乐观的平均年份(10%):2022

* 平均现实年份(50%):2040

* 平均悲观年份(90%):2075

普通受访者认为,在25年代,我们将有更多的AIS。 90发生OII的2075百分比概率意味着如果你现在还很年轻,这很可能发生在你的一生中。

James Barrat最近进行的另一项研究(着名且非常好的书“我们最后的发明”的作者,摘录自哪 我引起了读者的注意 Hi-News.ru)和Ben Herzel在专门讨论OII,AGI会议的年度会议上,简单地向人们展示了我们进入OII的年份:2030,2050,2100,之后或从未。 结果如下:

* 2030:42%的受访者

* 2050:25%

* 2100:20%

在2100之后:10%

从不:2%

它看起来像博斯特罗姆的结果。 在Barrat调查中,超过三分之二的受访者认为OII将在2050年度到来,不到一半的人认为OII将在下一个15年度出现。 同样令人惊讶的是,只有2%的受访者原则上不会在未来看到AIS。

但CSI并不像ICI那样是一个转折点。 据专家介绍,我们会有ICI吗?

当我们到达ISI时,博斯特罗姆采访了专家:a)到达AIS两年后(即几乎立即由于情报爆炸); b)在30年。 结果?

平均视图是从OII到ISI的快速转换,具有10百分比概率,但在30年或更短时间内,它将以75百分比概率发生。

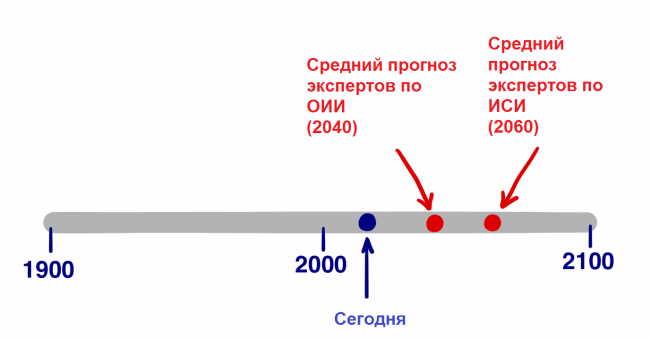

根据这些数据,我们不知道受访者称50发生ICI的几率是多少,但根据上面的两个答案,我们假设它是20年。 也就是说,AI领域的世界领先专家认为,转折点将在2060年度出现(OII将出现在2040年+ 20从OII过渡到IIS需要数年时间)。

当然,上述所有统计数据都是推测性的,只是代表了人工智能领域专家的意见,但它们也表明大多数有关人士都同意,通过2060,可能会出现ISI。 在短短几年45。

我们转向第二个问题。 当我们到达一个转折点时,致命选择的哪一方将决定我们?

超级智能将是强大的,对我们来说关键问题将是:

谁或什么将控制这种力量,它的动机是什么?

这个问题的答案将取决于ISI是否会获得一个令人难以置信的强大发展,一个无法估量的可怕发展,或者这两个选项之间的关系。

当然,专家团体正试图回答这些问题。 Bostroma调查分析了OII对人类影响的可能后果的可能性,事实证明,随着52百分比的可能性,一切进展顺利,并且31百分比机会一切都变得糟糕或非常糟糕。 Hi-News的亲爱的读者们,在本主题前一部分的最后部分进行的调查显示了相同的结果。 对于相对中性的结果,概率仅为17%。 换句话说,我们都相信OII的出现将是一件大事。 值得注意的是,这项调查涉及OII的出现 - 在ICI的情况下,中立的百分比将会更低。

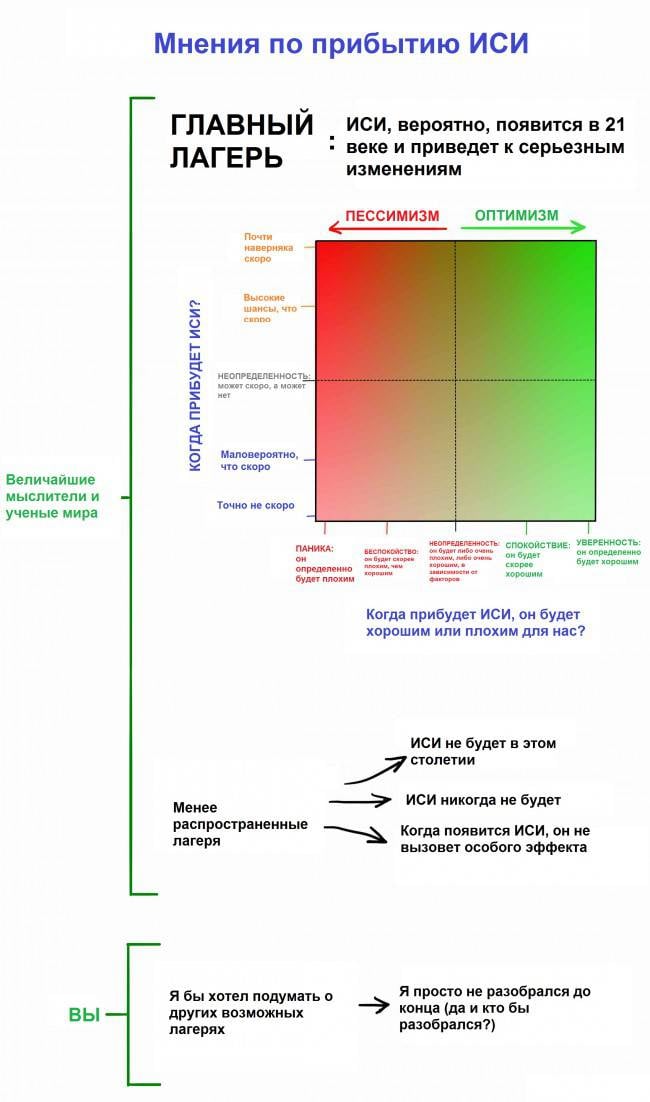

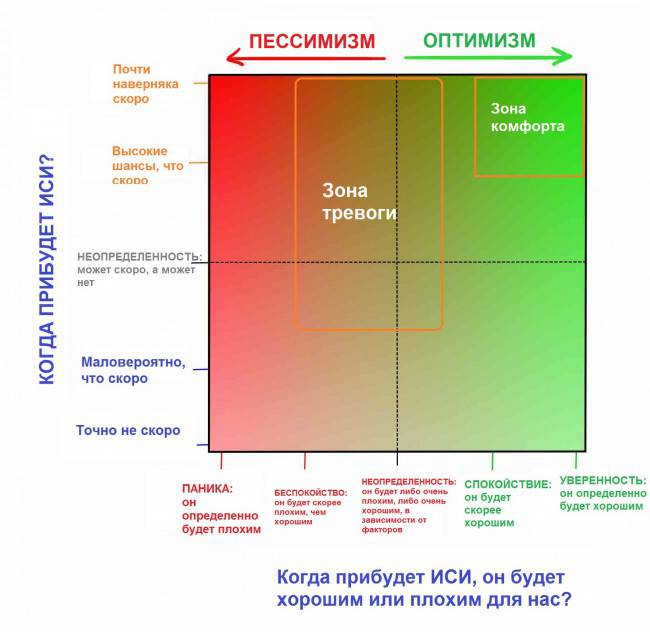

在我们进一步深入讨论问题的不良和好的方面之前,让我们结合问题的两个部分 - “这会发生什么时候?”和“好或坏?”进入一个涵盖大多数专家意见的表格。

我们将在一分钟内谈论主要营地,但首先要确定你的位置。 在你开始处理这个话题之前,最有可能的是,你和我在同一个地方。 人们通常不会考虑这个主题有几个原因:

* 如第一部分所述,电影严重混淆了人与事实,用人工智能呈现不切实际的场景,这导致我们不应该认真对待人工智能。 詹姆斯·巴拉特将这种情况与疾病控制中心在未来对吸血鬼发出严重警告这一事实进行了比较。

* 由于所谓的认知偏见,只要我们没有证据,我们就很难相信事物的真实性。 你可以自信地想象今年的1988计算机科学家,他们经常讨论互联网出现的深远影响及其可能变成什么,但人们几乎不相信它会改变他们的生活直到实际发生。 计算机根本不知道如何在1988中执行此操作,人们只是看着他们的计算机并想:“说真的? 这是世界将改变的吗?“ 他们的想象力受到他们个人经历教导他们的想象力的限制,他们知道计算机是什么,并且很难想象计算机将来会变成什么样。 人工智能正在发生同样的事情。 我们听说这将是一件严肃的事情,但由于我们还没有面对面地面对他,总的来说,我们在现代世界中看到人工智能的相当微弱的表现,我们很难相信他会从根本上改变我们的生活。 所有难民营的众多专家以及有兴趣的人都试图通过日常集体自我中心主义的噪音来引起我们的注意,这是违背这些偏见的。

* 即使我们相信这一切 - 你有多少次想过你将永远度过余下的这一事实? 一点点,同意。 即使这个事实比你每天做的更重要。 这是因为我们的大脑通常专注于日常生活中的小事,无论我们的长期处境多么疯狂。 简单地说,我们是如此安排的。

这篇文章的目标之一就是带你离开营地,叫做“我喜欢考虑其他事情”,并把专家放在营地里,即使你只是站在上面广场上两条虚线之间的十字路口,也是完全犹豫不决的。

在研究过程中,显而易见的是,大多数人的意见很快就朝着“主营”的方向发展,四分之三的专家分为主营地的两个分区。

我们将全面访问这两个难民营。 让我们开始吧。

为什么未来可能是我们最大的梦想?

当我们探索人工智能的世界时,我们惊奇地发现许多人处于舒适区。 右上方的人们兴奋地嗡嗡作响。 他们相信我们会落在原木的好方面,并且也相信我们将不可避免地遇到这个问题。 对他们来说,未来只是人们梦寐以求的最好。

将这些人与其他思想家区别开来的观点并不是他们想要在幸福的一面 - 但他们确信她正在等待我们。

这种信心源于争议。 批评者认为,它来自于令人眩目的兴奋,这可能会使潜在的消极方面蒙上阴影。 但支持者表示,悲观的预测总是天真的; 技术的不断发展将永远帮助我们。

您有权选择任何这些意见,但抛开怀疑并好好看看平衡日志的幸福一面,试图接受这样一个事实,即您阅读的所有内容可能已经发生。 如果你向狩猎采集者展示我们的舒适,技术和无限丰富的世界,他们对他们来说似乎是一个神奇的小说 - 我们表现得非常谦虚,无法承认未来等待我们的同样难以理解的转变。

Nick Bostrom描述了人工智能的超级系统可以采用的三种方式:

* 一个可以回答任何精确提出的问题的神谕,包括人们无法回答的复杂问题 - 例如,“如何提高汽车引擎效率?”。 谷歌是一个原始的神谕。

* 将执行任何高级命令的精灵 - 使用分子汇编程序创建一个新的,更有效的汽车引擎版本 - 并将等待下一个命令。

* 一个拥有广泛的权利和能够在世界上自由运作,做出自己的决定并改进过程的主权者。 他将发明一种更便宜,更快捷,更安全的私人旅行方式。

这些对我们来说似乎很难的问题和任务看起来像是一个超级系统,如果有人要求改善“我的铅笔从桌子上掉下来”的情况,你只需将它抬起并放回去。

美国人工智能专家Eliezer Yudkovsky非常注意到:

“不存在困难问题,只有某些智力水平难以解决的问题。 上升(在智力方面),一些问题突然从“不可能”的范畴变为“显而易见”的阵营。 高出一步 - 他们都将变得明显。“

有许多不耐烦的科学家,发明家和企业家在我们的桌子上选择了一个自信舒适的区域,但是为了在这个世界上最好的步行,我们只需要一个指南。

Ray Kurzweil引起双重感觉。 有些人崇拜他的想法,有些人鄙视他。 一些人留在中间 - 道格拉斯·霍夫斯塔特,讨论Kurzweil书籍的想法,雄辩地指出“就好像你吃了很多美食和一个小狗便便,然后把所有东西混合在一起,这样就不可能理解什么是好的,什么是坏的。”

无论你是否喜欢他的想法,都不可能在没有兴趣的情况下通过它们。 他开始在青少年时期发明东西,并在接下来的几年中发明了几件重要的东西,包括第一台平板扫描仪,第一台文字转语音扫描仪,着名的Kurzweil音乐合成器(第一台真正的电钢琴),以及第一台商业上成功的语音识别器。 他也是五本耸人听闻的书籍的作者。 Kurzweil因其大胆的预测而受到赞赏,他的“跟踪记录”相当不错 - 在80结束时,当互联网还处于起步阶段时,他建议在2000年代,网络将成为一种全球现象。 华尔街日报称Kurzweil是一个“不安的天才”,福布斯,一个“全球思维机器”,Inc。 杂志是“爱迪生的合法继承人”,比尔盖茨是“预测人工智能未来的最佳人选”。 在2012中,Google的联合创始人拉里佩奇邀请Kurzweil担任技术总监一职。 在2011,他共同创办了奇点大学,该大学庇护着美国宇航局,部分由谷歌赞助。

他的传记很重要。 当Kurzweil谈到他对未来的看法时,看起来很疯狂,但真正疯狂的是他远非疯狂 - 他是一个非常聪明,受过良好教育和理智的人。 你可能认为他在预测中错了,但他不是傻瓜。 Kurzweil的预测由“舒适区”的许多专家分享,Peter Diamandis和Ben Herzel。 这就是他认为会发生的事情。

年表

Kurzweil认为计算机将达到2029的一般人工智能(OII)水平,而2045不仅会产生人工超级智能,还会产生一个全新的世界 - 即所谓的奇点。 他的人工智能年表仍然被夸大了,但在过去的15年代,狭隘人工智能(AII)系统的快速发展使许多专家转向Kurzweil。 他的预测仍然比Bostrom的调查(OII到2040,IIS到2060)更加雄心勃勃,但不是很多。

根据Kurzweil的说法,今年2045的独特性导致了生物技术,纳米技术以及更重要的AI领域的三次同步革命。 但在我们继续 - 纳米技术不断追随人工智能之前,让我们花点时间学习纳米技术。

关于纳米技术的几句话

我们通常将纳米技术称为处理1-100纳米内物质的操作。 纳米是十亿分之一米,或百万分之一毫米; 在1-100纳米范围内,您可以拟合病毒(100 nm),DNA(10 nm宽),血红蛋白分子(5 nm),葡萄糖(1 nm)等。 如果纳米技术对我们有用,那么下一步将是使用最小一个数量级(〜,1 nm)的单个原子进行操作。

为了理解人们遇到问题的地方,试图控制如此规模的问题,让我们进一步扩大规模。 国际空间站位于距离地球一公里的481。 如果人们成为巨人并用头撞到国际空间站,他们将比现在多250 000倍。 如果您在1 100时间内将某些东西从250增加到000纳米,您将获得2,5厘米。 纳米技术相当于一个ISS高轨道的人试图控制一粒沙子或眼球的大小。 为了达到一个新的水平 - 控制单个原子 - 巨人必须仔细定位直径为1 / 40毫米的物体。 普通人需要用显微镜才能看到它们。

Richard Feynman首次在1959上谈到了纳米技术。 然后他说:“就我所知,物理学原理并不反对以原子为原子控制事物的可能性。 原则上,物理学家可以合成化学家记录的任何化学物质。 怎么样? 通过将原子放置在化学家所说的物质上。“ 这一切都很简单。 如果您知道如何移动单个分子或原子,您几乎可以做任何事情。

纳米技术在1986中成为一个严肃的科学领域,当时工程师埃里克·德雷克斯勒在他的基础书“创造机器”中展示了他们的基础知识,然而德雷克斯勒自己认为那些想要更多地了解纳米技术中的现代思想的人应该阅读他的年度2013一书“总丰度“(Radical Abundance)。

关于“灰色粘液”的几句话

深化纳米技术。 特别是,“灰色粘性”的主题是纳米技术领域不是最令人愉快的主题之一,这是不可能说的。 在纳米技术理论的旧版本中,提出了一种纳米级方法,其中涉及创建数万亿个微小的纳米机器人,它们可以共同创造一些东西。 创造数万亿纳米机器人的方法之一是创造一个可以自我复制的方法,即从一个 - 两个,两个 - 四个,等等。 白天将出现数万亿的纳米机器人。 这就是指数增长的力量。 好笑不是吗?

这很有趣,但直到它导致了一场大灾难。 问题在于指数增长的力量,使得快速创建万亿纳米机器人非常方便,使自我复制成为一个可怕的事情。 如果系统关闭,而不是停止几万亿的复制,纳米机器人会继续增加怎么办? 如果整个过程依赖于碳会怎么样? 地球的生物量含有碳原子10 ^ 45。 纳米机器人必须由10 ^ 6碳原子的顺序组成,因此10 ^ 39纳米机器人将吞噬地球上的所有生命,这将仅在130重复中发生。 纳米机器人的海洋(“灰色粘性物质”)将淹没地球。 科学家认为纳米机器人可以在100秒内复制,这意味着一个简单的错误可以在3,5小时内杀死地球上的所有生命。

如果纳米技术是由恐怖分子和不利的专家手中达成的话,可能会更糟。 他们可以创造数万亿的纳米机器人,并将它们编程,在几周内静静地传播到世界各地。 然后,只需点击一下按钮,在90分钟内他们就会吃掉所有东西,没有机会。

尽管这个恐怖故事已被广泛讨论多年,但好消息是这只是一个恐怖故事。 最近创造了“灰色粘性”一词的埃里克·德雷克斯勒(Eric Drexler)最近说:“人们喜欢恐怖故事,这个故事属于关于僵尸的恐怖故事。 这个想法本身已经在吃脑筋。“

在我们深入了解纳米技术之后,我们可以利用它们创造技术设备,服装,食品,生物产品 - 血细胞,抗病毒和癌症的战斗机,肌肉组织等等。 在使用纳米技术的世界中,材料的成本将不再与其制造工艺的短缺或复杂性相关联,而是与原子结构的复杂性相关联。 在纳米技术的世界里,钻石可以成为更便宜的橡皮擦。

我们还没有结束。 并不完全清楚,我们低估或高估了这条道路的复杂性。 然而,一切都归功于纳米技术并不遥远。 Kurzweil建议,在2020年代,我们将拥有它们。 世界各国都知道纳米技术可以保证一个美好的未来,因此投入数十亿美元。

想象一下,如果超级智能计算机进入可靠的纳米级汇编程序,它将获得什么样的可能性。 但是纳米技术是我们的想法,我们正试图驾驭它,这对我们来说很难。 如果对于ISI系统他们只是一个笑话,并且ISI本身会提出有时比我们通常可以假设的任何东西更强大的技术呢? 我们同意:没有人可以假设人工智能能够做什么? 据信,我们的大脑甚至无法预测到最低限度。

AI能为我们做些什么?

凭借超级智能和超级智能可以创造的所有技术,ICI可能能够解决人类的所有问题。 全球变暖? ISI将首先通过发明一系列与化石燃料无关的能源生产方式来阻止碳排放。 然后,他将提出一种有效的创新方法,从大气中去除多余的CO2。 癌症和其他疾病? 不是问题 - 医疗保健和医学将以一种无法想象的方式改变。 世界饥饿? ICI将使用纳米技术制作与天然,从头开始,真正的肉类相同的肉类。

纳米技术将能够将一堆垃圾变成一大桶新鲜肉类或其他食物(甚至不一定以熟悉的形式 - 想象一个巨大的苹果立方体),并使用先进的运输系统将所有这些食物传播到世界各地。 当然,对于不再需要为食物而死的动物来说,这将是非常好的。 ICI还可以做很多其他事情,比如拯救濒临灭绝的物种,甚至已经从储存的DNA中灭绝。 CII可以解决我们最困难的宏观经济问题 - 我们最困难的经济辩论,道德和哲学,世界贸易 - 所有这些对于CII来说都是非常明显的。

但是CII可以为我们做些特别的事情。 迷人和戏弄会改变一切: CII可以帮助我们处理死亡率。 逐渐掌握AI的可能性,您也可能会重新考虑所有关于死亡的想法。

Evolution没有理由延长我们的寿命比现在更长。 如果我们活得足够长,可以分娩并将孩子培养到能够自立的程度,那么这种进化就足够了。 从进化的角度来看,30 +有足够的发展年限,没有理由延长寿命并降低自然选择的价值。 威廉巴特勒耶茨称我们的物种“灵魂附着在垂死的动物身上”。 不是很有趣。

由于我们有一天都会死去,所以我们认为死亡是不可避免的。 我们考虑随着时间的推移老化 - 继续前进而无法阻止这个过程。 但是死亡的想法是危险的:被它捕获,我们忘记了生存。 Richard Feynman写道:

“生物学中有一个奇妙的东西:这门科学中没有任何东西能说出死亡的必要性。 如果我们想要创建一个永动机,我们就会明白,我们已经在物理学中找到了足够的规律,这些规律要么表明不可能,要么就是法律错误。 但在生物学方面,没有任何迹象表明死亡的必然性。 这让我相信它不是那么不可避免,生物学家找到这个问题的原因只是时间问题,这种可怕的普遍疾病,它将被治愈。“

事实是衰老与时间无关。 老化是身体的物理材料磨损。 汽车的部件也会降级 - 但这种老化是不可避免的吗? 如果您在零件磨损时修理汽车,它将永远有效。 人体没有什么不同 - 只是更复杂。

Kurzweil谈论血液中智能的,Wi-Fi连接的纳米机器人,可以执行无数的人类健康任务,包括定期修复或更换身体任何部位的磨损细胞。 如果你改进这个过程(或找到一个更智能的ICI提出的替代方案),它不仅可以保持身体健康,还可以逆转衰老。 60岁和30岁的身体之间的差异在于少数几个可以用正确的技术纠正的物理时刻。 ISI可以制造一辆可以作为60岁的人参观的汽车,并且可以获得一个30岁的汽车。

即使是有辱人格的大脑也可以更新。 ISI肯定知道如何在不影响大脑数据(个性,记忆等)的情况下做到这一点。 90岁,患有完全的大脑退化,可以重新训练,升级,并回到他生命的开始。 这可能看起来很荒谬,但是身体是少数几个原子,CID可能很容易用任何原子结构来操纵它们。 一切都不是那么荒谬。

Kurzweil还认为,随着时间的推移,人造材料将越来越多地融入体内。 首先,器官可以被超级先进的机器版本取代,这些机器版本将永远工作并且永不失败。 然后,我们可以重新设计一个完整的身体,用理想的纳米机器人取代红血球,这些机器人可以自行移动,从而消除了对心脏的需求。 我们还可以提高我们的认知能力,开始更快地思考数十亿,并使用云访问人类可用的所有信息。

理解新视野的可能性将是无限的。 人们已经设法赋予性别以新的约会;他们为了娱乐而从事它,而不仅仅是为了繁殖。 Kurzweil认为我们可以用食物做同样的事情。 纳米机器人可以直接向身体细胞提供完美的营养,让不健康的物质通过身体。 纳米技术理论家罗伯特弗雷塔斯已经开发出血细胞替代品,当在人体内实施时,可能让他不能呼吸15分钟 - 这是人类发明的。 想象一下,当权力获得ICI时。

毕竟,Kurzweil相信当人们变得完全虚伪时,他们会达到一个目的; 我们将研究生物材料并思考它们有多原始的时候; 我们将阅读关于人类历史早期阶段的时间,惊叹于微生物,事故,疾病或老年人如何能够违背自己的意愿杀死一个人。 最终,人们将击败他们自己的生物并变得永恒 - 这是通往平衡木幸福一面的道路,我们从一开始就谈到这一点。 相信它的人也确信这个未来很快就会等待我们。

Kurzweil的想法引起了严厉的批评,你当然不会感到惊讶。 他在2045年度中的独特性以及随后的人类永生被称为“神经的提升”或“智商140的合理创造” 其他人质疑乐观的时间框架,对人体和大脑的理解,让他想起了摩尔定律,这个定律还没有出现。 对于每一个相信Kurzweil思想的专家来说,有三个人认为他是错的。

但最令人感兴趣的是,大多数不同意他的专家并不认为这是不可能的。 他们没有说“胡说八道,这种情况永远不会发生”,而是说“如果我们到达ISI,这一切都会发生,但这只是一个问题。” 博斯特罗姆是公认的AI专家之一,警告人工智能的危险,他也承认:

“不可能至少存在一些超级智能无法解决或至少帮助我们解决的问题。 疾病,贫困,环境破坏,各种苦难 - 所有这些超级智能在纳米技术的帮助下将能够在一瞬间解决。 此外,超级智能可以通过停止和逆转衰老过程,使用纳米医学或将我们加载到云中的能力,为我们提供无限的生命。 超级智能还可以为智力和情感的可能性创造无限增长的机会; 他可以帮助我们创造一个我们将生活在快乐和理解中,接近我们的理想并定期实现我们梦想的世界。“

这是Kurzweil批评者之一的引用,但是,如果我们成功创建了一个安全的ISI,那么这一切都是可能的。 Kurzweil简单地确定了人工智能应该是什么,如果有可能的话。 如果他是一个好神。

对“舒适区”的支持者最明显的批评是,在评估ICI的未来时,他们可能是错误的。 Kurzweil在他的着作Singularity中,将20的700页面用于潜在的ISI威胁。 问题不在于我们进入ISI时,问题是他的动机是什么。 Kurzweil谨慎地回答这个问题:“ISI起源于许多不同的努力,并将深深融入我们文明的基础设施。 事实上,它将与我们的身体和大脑紧密结合。 它将反映我们的价值观,因为它将与我们合而为一。“

但如果答案是,为什么这个世界上那么多聪明人都担心人工智能的未来呢? 斯蒂芬霍金为什么说ICI的发展“可能意味着人类的终结”? 比尔盖茨说,他“不理解那些不关心的人”。 伊隆马斯克担心我们“召唤恶魔”。 为什么许多专家认为ISI是对人类的最大威胁?

我们下次会谈这个。

基于waitbutwhy.com,由Tim Urban编写。 本文借鉴了尼克·博斯特罗姆,詹姆斯·巴瑞特,光芒Kurzweil,周杰伦尼尔斯 - 尼尔森,史蒂芬·平克,弗诺·文奇,摩西·瓦迪,拉斯·罗伯茨,斯图尔特Armstroga和凯细胞,苏珊·施耐德,斯图尔特罗素和彼得·诺维格,西奥多·莫迪塞,加里工作Marcus,Carl Schulman,John Searle,Jaron Lanier,Bill Joy,Kevin Keli,Paul Allen,Stephen Hawking,Kurt Andersen,Mitch Kapor,Ben Herzel,Arthur Clarke,Hubert Dreyfus,Ted Greenwald,Jeremy Howard。

信息