人类心灵手记:美国人要改变军事人工智能

资料来源:vgtimes.ru

数字非人化被取消了吗?

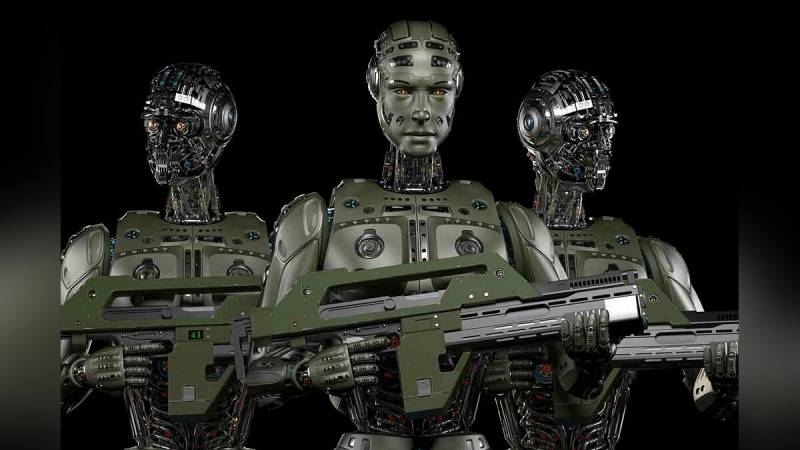

首先,来自军事 AI 战士的警告:

“机器不把我们看作人,对他们来说,人只是一段需要处理和整理的代码。 从智能家居到使用狗——机器人 警察、人工智能技术和自动化决策开始在我们的生活中发挥重要作用。 在一排数字设备的最末端是杀手机器人。 如果我们允许相关的非人性化,我们很快就会努力保护自己免受生活其他领域机器做出的决定的影响。 我们需要首先禁止自治系统 武器以防止滑向数字非人化。”

要求冻结所有战斗人工智能工作的和平主义者分为两种类型。 首先是修改后的“终结者”和其他类似物。 第二 - 根据战斗机器人的现代能力评估未来。 首先,配备打击系统的有翼无人机。

无人机错误或故意破坏平民的事件已经够多了。 在中东,美国 无人机 毁掉不止一场婚礼。 飞行机器人操作员将庆祝的空对空射击确定为游击队交火的标志。 如果一个受过专门训练的人都不能从几百米外确定目标的细节,那我们还谈什么人工智能。 目前,机器视觉在图像感知的充分性方面,无法与人眼和大脑相提并论。 除非他累了,但这也可以通过及时更换接线员来解决。

乌云显然笼罩着军事人工智能。 一方面,越来越多的证据表明这一领域的技术突破迫在眉睫。 另一方面,越来越多的声音支持限制甚至禁止这方面的工作。

一些例子。

2016 年,出现了一份请愿书,著名思想家和其他数千人要求不要为人工智能提供致命武器。 签署者包括斯蒂芬霍金和埃隆马斯克。 七年来,请愿书已收集到超过20个签名。 除了与不受控制地破坏人类的可能性相关的纯粹人道主义恐惧之外,还存在法律上的矛盾。

如果修复人工智能犯下的战争罪行,谁将受到审判? 烧毁数个平民村庄的无人机操作员很容易找到并受到相应的惩罚。 人工智能是程序员集体工作的产物。 这里很难吸引一个人。 或者,您可以判断制造公司,例如同一家波士顿动力公司,然后判断谁将参与自主无人机的生产。 很少有人会渴望站在纽伦堡第二法庭的被告席上。

资料来源:韩国门户网站

大概正是因为这个原因,工业家和程序员们都在试图减缓人工智能战斗技能的发展。

例如,在 2018 年,大约 XNUMX 家 IT 公司和近 XNUMX 名程序员承诺不在战斗自主系统上工作。 谷歌声称,他们将在五年内完全放弃人工智能领域的军事合同。 据传说,这种和平主义并非偶然——程序员得知他们正在为军事系统编写代码后,威胁要集体退出。 结果,他们找到了一个友好的选择——现有合同正在完成,但新合同尚未签订。 有可能在接近拒绝在战斗人工智能上工作的日期时,顽固的“程序员”将被解雇,取而代之的是同样有才华的人。 比如来自长期以来以廉价的智力资源着称的印度。

然后是 Stop Killer Robots 办公室,呼吁世界各国领导人签署类似禁止战斗人工智能的公约。 到目前为止没有成功。

所有这些都让军方官员寻找变通办法。 不到一小时的选举就将赢得美国总统,不仅承诺普惠 LGBT,还禁止改进军事人工智能。

人工智能的人类思维

五角大楼似乎即将在人工智能领域取得某种突破。 或者他对此深信不疑。 没有其他方法可以解释监管自主战斗系统人性化的新指令的出现。 美国国防部副部长凯瑟琳·希克斯 (Kathleen Hicks) 评论道:

“鉴于我们周围正在发生的重大技术进步,更新我们关于武器系统自主性的指令将有助于我们不仅在新系统的开发和部署方面,而且在安全领域保持世界领先地位。”

你听说过每个人都对自主杀手机器人感到敬畏吗? 美国的人工智能今后将是最人性化的。 就像美国人自己一样。

资料来源:robroy.ru

问题是,没有人真正了解如何向携带武器的机器人灌输臭名昭著的“人类对使用武力的判断”。 去年 XNUMX 月底更新的概念中的确切措辞:

“自主和半自主武器系统的设计将使指挥官和操作员能够对武力的使用进行适当水平的人类判断。”

在这里,例如,如果在打扫房屋时,攻击机首先将手榴弹扔进房间,然后进入自己。 这是人的判断吗? 当然,而且没有人有资格评判他,尤其是他之前喊出“有人吗?”的时候。 如果自主机器人按照相同的方案工作呢?

人类判断是一个过于宽泛的概念,无法以任何方式加以限制。 乌克兰武装部队战士处决俄罗斯战俘也是人的思维吗?

五角大楼指令 3000.09 中关于自主作战系统的补充充满了陈词滥调。 例如,

“授权使用、直接使用或操作自主和半自主武器系统的人员必须尽职尽责,并遵守战争法、适用条约、武器系统安全规则和适用的交战规则。”

显然,在此之前,他们工作不谨慎,不符合战争法。

与此同时,美国和欧洲媒体对五角大楼 XNUMX 月份的倡议没有任何批评的迹象。 在人工智能虚假的人性化之下,无非是企图掩饰正在发生的事情。 现在美军在军队中对抗人工智能对手,将拥有坚实的王牌。 看,我们没有简单的人工智能,而是具有“正确的人类判断水平”。

考虑到“人工智能”还没有一个明确且普遍接受的定义,围绕它的所有字母创作都带有讽刺意味。 至少。

如何让处理大数据数组的数学算法发挥人的判断作用?

更新后的指令 3000.09 没有回答这个主要问题。

信息